設計與使用 AI 的潛在問題:道德上的責任分散

如果 AI 100% 準確,問題就解決了嗎?

在上篇《演算法的偏見與歧視如何形成》我整理了一些 AI 可能加深偏見與歧視的設計瑕疵,現今已經有眾多研究領域致力於減少演算法的偏見,這是一個在研究領域早就被意識到的問題。

然而 AI 有沒有偏見、或者夠不夠精準,真的是最重要的問題嗎?

所謂的偏見是指人類在理解一個事物之前,就妄下斷言貼上一個不符合事實的標籤,但就算 AI 沒有偏見,能將所有問題不偏不倚地回答事實,問題也並不會隨之消失。

真正嚴重的問題從來都不是在 AI 本身,而是人類自己,除非強人工智慧誕生的那天到來。

用一個簡單的譬喻:我們假設有一個演算法,它知道任何問題的答案,比如你選舉會投給誰、隔壁老王喜歡吃什麼食物、一群男女當中有幾個人是廚師、它當然也知道不同膚色的人種犯罪率分別是多少,全部的數字都是正確答案。

那麼,這麼完美的 AI 就不會帶來偏見問題嗎?答案是否定的:越是強大的力量,問題就跟力量本身的瑕疵越無關,而是取決於使用的人。

使用者的問題遠大於 AI 的瑕疵

如果你擔心哪個國家領導人衝動決策拿核子武器開戰,大過它自己設計不良而失控自爆;那你就會擔心使用 AI 的人錯誤地解讀結果、制定出歧視的政策,遠大於 AI 本身的不準確。

換句話說,只要 AI 沒有自己的意識,最終怎麼解讀、採取行動的方式仍然取決於人類:如果使用的人抱著錯誤的想法去使用 AI 模型,那不管數據集是如何的精確、完美,都可能被拿去應用在壞的方向上。

什麼情況下是「準確的模型、壞的應用」?舉例來說,一個能 100% 預測收入的模型,被國家用來禁止窮人進入餐廳、百貨消費,或是拒絕提供窮人基本的醫療服務;或是被犯罪集團拿去搜尋有錢人,當做偷竊、綁架的目標。

在這些情況下,AI 越準確,反而會讓問題更嚴重。

Google 內部就曾經有人對「演算法的公平性」這樣評論:

Fairness of an algorithm depends in part on how it’s used(演算法的公平性取決於它如何被使用)

演算法反映的是價值觀

我在《平台不是媒體?談抖音CEO張一鳴的詭辯》當中提到:「不管作者是有意識或無意識,任何演算法的行為都代表了一種價值觀」。

廣告促銷的精準估計?

一個常出現的促銷方式,就是給不同人不等價的折價券,拜大數據與演算法所賜,系統可以找到一個對公司營利最有效的折價券配發策略,當這件事情發生在旅遊、奢侈品上的時候,因為不是必需品,大家並不會覺得有什麼問題。

但若我們把場景換到生活用品來看,便衍生出一個問題:要把折價券給一個有錢人讓公司賺錢?還是給窮人比較符合社會正義?是給願意消費的人衝業績?還是真正需要的人物盡其用?不管用什麼標準,都不太可能是完全公平的。

信用分數的精準估計?

我們可以再換個角度看,中國已經向全世界展示了無數基於「信用分數」的系統實踐,比如「信用破產」的人不能買車票,而這個「信用分數」到底是你真的沒有錢,還是你發表了不好的言論,導致成為演算法背後操縱者的眼中釘,我們就不得而知了。

一個非常精準的社會信用分數系統,可以是給優質顧客更好的服務、可以是經濟上加大貧富差距的政策、也可以體現在思想控制,端看演算法背後是基於什麼理念設計。

人命價值的精準估計?

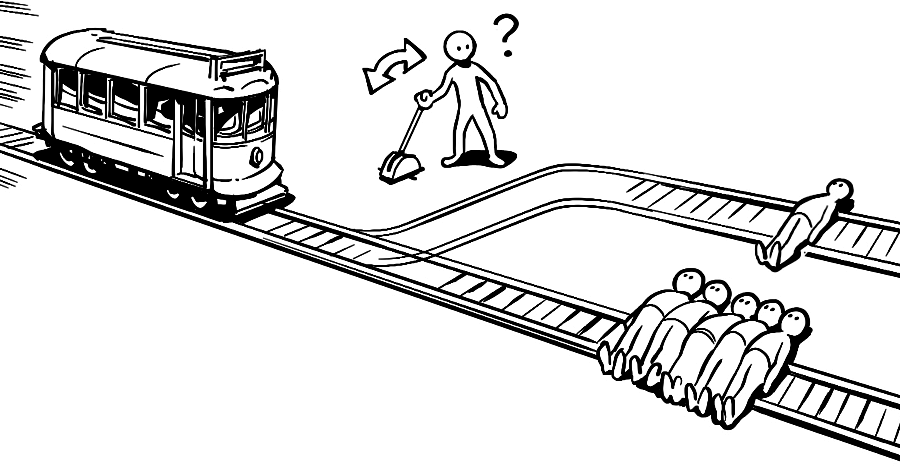

電車難題是一個經典的哲學題目,如果你把人命視為等價,那你或許會認為應該犧牲一個人、拯救五個人;但如果再把問題弄得複雜一點,其中那一個人是個偉人,五個人是凡人、又或者那一個人是世界首富,五個人則是殺人犯,我們該怎麼判斷該救誰?

假設 AI 演算法可以精準地算出關於這些人的所有答案,我們就有辦法輕易的決定嗎?答案是否定的,因為每個問題都帶有價值觀。

當我們告訴 AI 每個人命的價值是一樣的時候,我們是在實踐「人命均等」的價值觀;當我們告訴 AI 用每個人的財產當做標準的時候,我們是在實踐「有錢人比較值得救」的價值觀;當我們告訴 AI 用道德、犯罪當做標準的時候,我們是在實踐「道德至上」的價值觀。

但不管是哪種價值觀,都一定可以找到有爭議的地方。

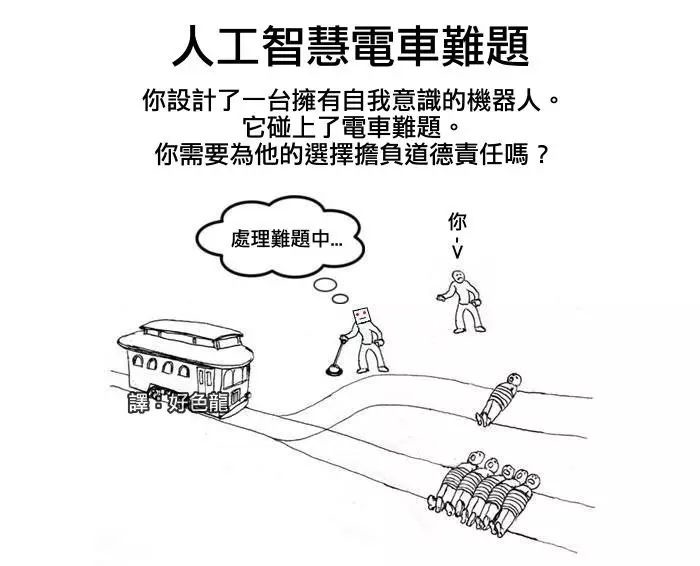

「你應該為自己設計的機器人對電車難題的選擇負責嗎?」放眼望去現在已經很多決策有人工智慧的參與,但發生問題的時候仍然只有人可以負責,因為演算法全都是人決定的。

比如自駕車選擇撞一個小孩,而不是三個大人、比如銀行放款演算法判斷不貸款,結果公司倒閉,老闆跳樓,像這些問題發生的時候,應該是設計演算法的工程師負責?還是提供硬體的零組件工廠?或是產品經理?CEO?董事會?全體股東?演算法造成責任更加分散,這就是我們正在面臨的問題。

責任分散是一種社會心理學現象,指對某一件事來說,如果是要求一個群體共同完成任務、且沒有明確責任分配的趨向,群體中的每個個體的責任感就會很弱。這種心態可見於短語「沒有一滴雨認為是自己造成水災。」 「責任分散」的例子包括團體迷思和旁觀者效應,而「責任分散」的實質影響就是人多不負責,責任不落實。

我們還沒準備好成為「神」

在數據夠多的情況下,機器學習會比人類做出更合理的決策,但合理不能代表道德,因為合理的「理」通常只遵循某個特定指標,而非全面性的思考。

人類常常會做出乍看之下不合理的決策,比如借錢給比較不可能還的人、將機會給了比較不會成功的人、投資一筆看起來很不划算的生意、做出對自己有害的衝動行為。

根據個人經驗的不同,我們本來就會對同一個客觀事實有不同的主觀看法。當按鈕在人類手上的時候,我們都清楚也承擔了這些道德風險;但當一群人製造了 AI,並交給機器執行時,一切的衡量都變成冷冰冰的計算,有些人可能就認為這些責任與他毫不相干。

所謂的「偏見」指的是我們在還沒認識一個人之前,就擅自用一個族群的標籤去定型他、認為他一定具有某些特質;然而,AI 的「精準無偏見」在這個情況下,雖然可能不會造成歧視,卻「精準地」造成了問題。

我們願意將決定權,交給一個被人有意精心設計的演算法,或是一群無意、但沒有全面考慮道德與責任後果的設計者所製造出來的 AI 嗎?這個問題終究是在考驗我們對於人性的信任。